Debug-Gym: Como as IAs Estão Aprendendo a Debugar Código Igual Programadores

Você já percebeu como as ferramentas de IA para programação estão bombando por aí? Pois é, não é só impressão sua. Elas estão mudando completamente o jeito como a gente desenvolve software. E olha só o que o CEO do GitHub, Thomas Dohmke, falou ano passado: “Mais cedo ou mais tarde, 80% do código vai ser escrito pelo Copilot”. Não é pouca coisa, né? E não pense que isso é coisa do futuro distante, conheça um pouco do Debug-gym.

Empresas grandes e pequenas já estão usando IA pra caramba na hora de gerar código. O Garry Tan, da Y Combinator, soltou uma estatística que deixa a gente de queixo caído: em um quarto das startups da última turma deles, 95% do código foi escrito por modelos de linguagem grandes (LLMs). É muita coisa!

A Verdadeira Dor de Cabeça dos Programadores

Mas vamos combinar, quem programa sabe que o bicho pega mesmo é na hora de debugar. A real é que a maioria dos desenvolvedores passa muito mais tempo consertando bugs do que escrevendo código novo. Como mantenedores de repositórios open-source populares, a gente sente isso na pele.

Imagina só: e se uma ferramenta de IA pudesse sugerir correções para centenas de problemas abertos, e tudo que a gente precisasse fazer fosse aprovar antes de fazer o merge? Seria incrível, né? Foi pensando nisso que decidimos explorar como ensinar as IAs a debugar código.

Mas o que é debugar, afinal? É aquele processo interativo e repetitivo de consertar código. A gente formula hipóteses sobre por que o programa deu pau, coleta evidências examinando valores de variáveis, muitas vezes usando ferramentas como o pdb (debugador Python). E repete esse ciclo até o código funcionar direitinho.

Onde as IAs Atuais Deixam a Desejar

As ferramentas de IA para programação que temos hoje já dão um baita help na produtividade. Elas são ótimas sugerindo soluções para bugs com base no código disponível e nas mensagens de erro. Mas, diferente da gente, essas ferramentas não buscam informações adicionais quando as soluções falham.

É tipo aquele amigo que tenta te ajudar com um problema, mas sem fazer as perguntas certas. Tem coisas que ficam sem solução, como nesse exemplo simples onde uma coluna mal rotulada deixa as ferramentas de IA atuais completamente perdidas. Isso acaba passando aquela sensação de que a IA não entende direito o contexto do problema.

Apresentando o Debug-Gym

Daí surgiu uma pergunta natural: até que ponto os LLMs podem usar ferramentas interativas de debug, como o pdb? Pra explorar essa questão, lançamos o debug-gym – um ambiente que permite que agentes de correção de código acessem ferramentas para buscar informações ativamente.

O debug-gym expande o espaço de ação e observação de um agente com feedback do uso de ferramentas, permitindo definir pontos de interrupção, navegar pelo código, imprimir valores de variáveis e criar funções de teste. Os agentes podem interagir com ferramentas para investigar o código ou reescrevê-lo, se estiverem confiantes.

Acreditamos que o debug interativo com as ferramentas certas pode capacitar os agentes de codificação a enfrentar tarefas reais de engenharia de software. As correções propostas por um agente com recursos de debug, e depois aprovadas por um programador humano, estarão fundamentadas no contexto da base de código relevante, na execução do programa e na documentação, em vez de depender apenas de palpites baseados em dados de treinamento vistos anteriormente.

Como Funciona o Debug-Gym

O debug-gym foi projetado e desenvolvido para:

- Lidar com informações em nível de repositório: o repositório completo fica disponível para os agentes, permitindo que naveguem e editem arquivos.

- Ser robusto e seguro: para proteger tanto o sistema quanto o processo de desenvolvimento, o debug-gym executa código dentro de contêineres Docker isolados. Isso isola o ambiente de execução, impedindo ações prejudiciais, mas ainda permitindo testes e depuração completos.

- Ser facilmente extensível: pensamos no debug-gym com extensibilidade em mente, dando aos desenvolvedores a possibilidade de adicionar novas ferramentas facilmente.

- Ser baseado em texto: o debug-gym representa informações de observação em texto estruturado (formato JSON, por exemplo) e define uma sintaxe simples para ações de texto, tornando o ambiente totalmente compatível com agentes modernos baseados em LLM.

Com o debug-gym, pesquisadores e desenvolvedores podem especificar um caminho de pasta para trabalhar com qualquer repositório personalizado e avaliar o desempenho do seu agente de depuração. Além disso, o debug-gym inclui três benchmarks de codificação para medir o desempenho dos agentes baseados em LLM na depuração interativa:

- Aider para geração de código simples em nível de função

- Mini-nightmare para exemplos curtos de código com bugs criados manualmente

- SWE-bench para problemas de codificação do mundo real que exigem uma compreensão abrangente de uma base de código grande e uma solução no formato de um pull request do GitHub

Se você quiser saber mais sobre o debug-gym e começar a usá-lo para treinar seus próprios agentes de depuração, dê uma olhada no relatório técnico e no GitHub.

Experimentos Iniciais: Resultados Promissores

Na nossa primeira tentativa de validar que os LLMs têm melhor desempenho em testes de codificação quando têm acesso a ferramentas de depuração, construímos um agente simples baseado em prompt e fornecemos acesso às seguintes ferramentas de depuração: eval, view, pdb, rewrite e listdir. Usamos nove LLMs diferentes como base para nosso agente.

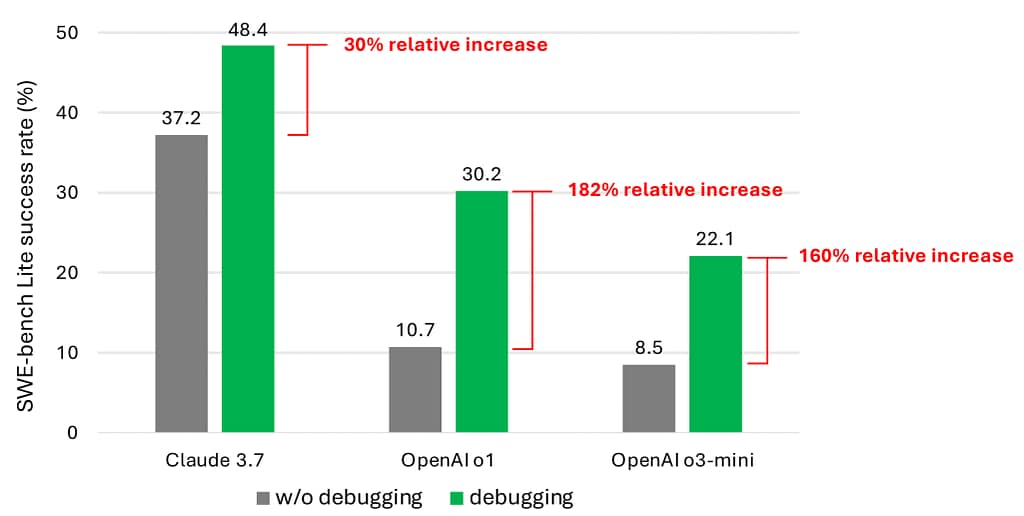

Mesmo com ferramentas de depuração, nosso agente simples raramente resolve mais da metade dos problemas do SWE-benchLite. Acreditamos que isso se deve à escassez de dados que representam comportamento de tomada de decisão sequencial (como traces de depuração) no corpus de treinamento atual dos LLMs.

No entanto, a melhoria significativa de desempenho (como mostrado nos resultados mais promissores no gráfico do artigo original) valida que esta é uma direção de pesquisa promissora. A taxa de sucesso representa a porcentagem dos 300 problemas do SWE-bench Lite resolvidos, comparando entre agentes com e sem ferramentas de depuração.

Os resultados mostram claramente que, quando equipados com ferramentas de depuração, os agentes conseguem resolver significativamente mais problemas. As barras verdes indicam o desempenho do agente com ferramentas de depuração, enquanto as barras cinzas mostram o desempenho do agente sem essas ferramentas. Vale ressaltar que ambos os agentes usam o mesmo LLM de base para tomar decisões e propor edições de código.

E aí, você já imaginou como seria ter uma IA te ajudando a encontrar aquele bug chato que você está há horas tentando resolver? Ou melhor ainda, resolvendo ele sozinha? Pois é, estamos cada vez mais perto disso!

O Futuro da Programação com IA

Tá na cara que o futuro da programação vai ser uma parceria entre humanos e IAs. A gente vai focar mais no lado criativo e estratégico, enquanto as IAs vão cuidar cada vez mais do trabalho pesado de codificação e depuração.

Mas calma, isso não significa que os programadores vão ficar sem emprego. Pelo contrário! Quem souber trabalhar bem com essas ferramentas vai ter uma vantagem e tanto. É como quando as calculadoras surgiram – não eliminaram os matemáticos, só permitiram que eles focassem em problemas mais interessantes.

No fim das contas, o debug-gym é só o começo de uma nova era na programação. Uma era onde a gente vai poder focar mais no “por quê” e menos no “como”. E, convenhamos, não é isso que todo programador sonha?

Perguntas Frequentes

O que exatamente é o debug-gym?

O debug-gym é um ambiente que permite que agentes de IA acessem e utilizem ferramentas de depuração interativas, como o pdb (Python debugger), para buscar informações ativamente e corrigir bugs de forma mais eficiente, similar ao processo que programadores humanos seguem.

As IAs realmente podem substituir programadores na depuração de código?

Não completamente. As IAs estão se tornando ferramentas poderosas para auxiliar na depuração, mas ainda precisam da supervisão humana para aprovar as correções propostas. O objetivo é formar uma parceria onde as IAs lidam com tarefas repetitivas, permitindo que os programadores foquem em aspectos mais criativos e estratégicos.

Quais são as principais limitações das ferramentas atuais de IA para codificação?

A principal limitação é que elas não buscam informações adicionais quando suas soluções iniciais falham. Diferente dos programadores humanos, que investigam ativamente o problema, as IAs atuais dependem principalmente dos dados disponíveis no momento, sem a capacidade de explorar o contexto mais amplo do código.

Como o debug-gym garante a segurança do código executado?

O debug-gym executa todo o código dentro de contêineres Docker isolados, criando um ambiente sandbox que impede ações potencialmente prejudiciais enquanto ainda permite testes e depuração completos.

Posso usar o debug-gym com meus próprios projetos ou repositórios?

Sim! O debug-gym foi projetado para ser flexível, permitindo que você especifique um caminho de pasta para trabalhar com qualquer repositório personalizado e avaliar o desempenho do seu agente de depuração nesse contexto específico.

Fonte: Microsoft Research Blog

Descubra mais sobre INFO 540º

Assine para receber nossas notícias mais recentes por e-mail.